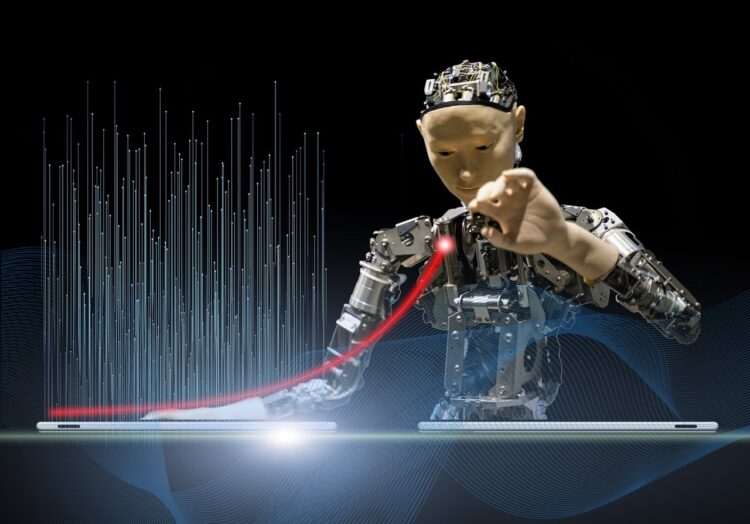

Umjetna inteligencija napreduje nevjerojatnom brzinom, čak i za pojmove onih koji prednjače u njenom razvoju. Zbog toga se sve češće mogu čuti vapaji za državnu pomoć, ali ne u smislu financija nego regulative.

Čelnici najvećih kompanija svijeta najčešće se bore protiv bilo kakve vrste državnih regulativa, zagovaraju slobodno tržište i vode se “najjači opstaju” retorikom, što samo potvrđuje da ih je uhvatila istinska panika kad se radi o umjetnoj inteligenciji.

To najbolje potvrđuju pozivi američkim vlastima, ali i vlastima drugih država svijeta, od strane lidera Googlea i OpenAI-a, kompanije koja stoji iza megapopularnog ChatGPT-a. Standarde i regulative žele iz jednostavnih razloga – kako bi se jasno postavile granice, smjernice i općenita pravila pri razvoju iznimno napredne tehnologije te njenog utjecaja na društvo u cijelosti.

Cilj je da se ne “otme kontroli”, ponajprije jer se može koristiti u svrhu naoružanja, kibernetičkog ratovanja, plasiranja dezinformacija i lažnih vijesti te brojne druge načine koji bi poništili njenu progresivnu ulogu u širem smislu.

“Da bismo imali dramatično prosperitetniju budućnost, moramo znati kako upravljati rizikom. Jer, već sad bi bilo teško i opasno zaustaviti kreiranje superinteligencije. Zato trebamo jasnije smjernice, kako bi svaki pojedinac imao potpunu kontrolu nad time kako koristiti umjetnu inteligenciju i u koje svrhe. Još uvijek ne znamo mehanizme kojima bi se uspostavila regulacija i sukladno tome kontrola, ali voljni smo eksperimentirati”, napisao je na službenom blogu izvršni direktor (CEO) OpenAI-a, Sam Altman.

Iako to nije rekao eksplicitno, najveći problem umjetne inteligencije je što se već na sadašnjim razinama može manipulirati pa koristiti za moralno upitne stvari. Oponaša ljudske glasove, može uređivati video i fotografiju na način da izgleda autentično, daje savjete o hakiranju, nesvjesno plasira dezinformacije i općenito čini sve što pojedinac zatraži.

Ako bi se sve nastavilo u smjeru kojim se sad krenulo, pitanje je vremena kad bi umjetna inteligencija mogla biti iskorištena u vojne svrhe. Ona nema savjest, etičke ili moralne dvojbe, funkcionira kako joj se kaže i može dovesto do katastrofičnog scenarija. Zato je polako stiglo vrijeme za neko međunarodno tijelo koje bi je kontrolirao, kao što Međunarodna agencija za atomsku energiju (IAEA) Ujedinjenih naroda nadgleda, regulira i ograničava uporabu nuklearne energije.

Ne čudi da lideri kompanija koji se bave umjetnom inteligencijom pozivaju na tako nešto jer time bi se oslobodili nepotrebne odgovornosti, koja bi bila prevelik teret za njih. Također, na taj način bi omogućili tehnologiju svima, ne samo nekolicini kompanija na svijetu. Čime se opet vraćamo na odgovornost.

“Umjetnu inteligenciju potrebno je regulirati na način koji bi uravnotežio inovativnost i potencijalnu štetu. I dalje vjerujem da je ta tehnologija previše važna da se ne bi regulirala i previše važna da se ne bi regulirala na dobar način. Ključna je u tom smislu međunarodna suradnja”, izjavio je Sundar Pichai, Googleov CEO, za Financial Times i dodao:

“Riječ je o najmoćnijoj tehnologiji s kojom se čovječanstvo ikad susrelo.”

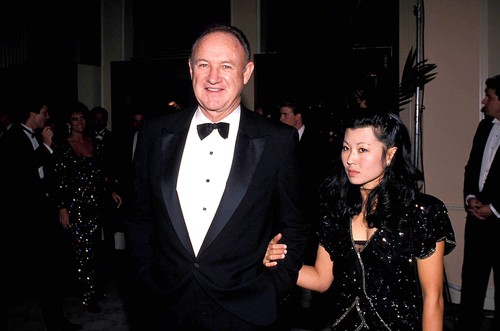

Ono na što treba pripaziti jest ne otići u smjeru restrikcija “upakiranih” u regulative, na što upozorava bivši Googleov CEO Eric Schmidt.

“Radije bih da se postigne dogovor između ključnih igrača i tako izbjegne utrka prema dnu”, bio je slikovit Schmidt.

Da to što se priča ima smisla, potvrđuje velika studija prestiženog američkog Sveučilišta Stanford na ovu temu. Čak 36 posto stručnjaka u njoj potvrđuje važnost umjetne inteligencije, ali i napominje da njene odluke mogu dovesti do nuklearne katastrofe, zbog čega treba raditi na prevenciji i onemogućiti da napravi tako nešto ako se nađe u krivim rukama.

N1 pratite putem aplikacija za Android | iPhone/iPad i mreža Twitter | Facebook | Instagram | TikTok.

Kakvo je tvoje mišljenje o ovome?

Budi prvi koji će ostaviti komentar!