AI vs istina

"Hej @Grok, je li ovo istina?" AI širi dezinformacije pa izmišljava "činjenice" kako bi ih potvrdio

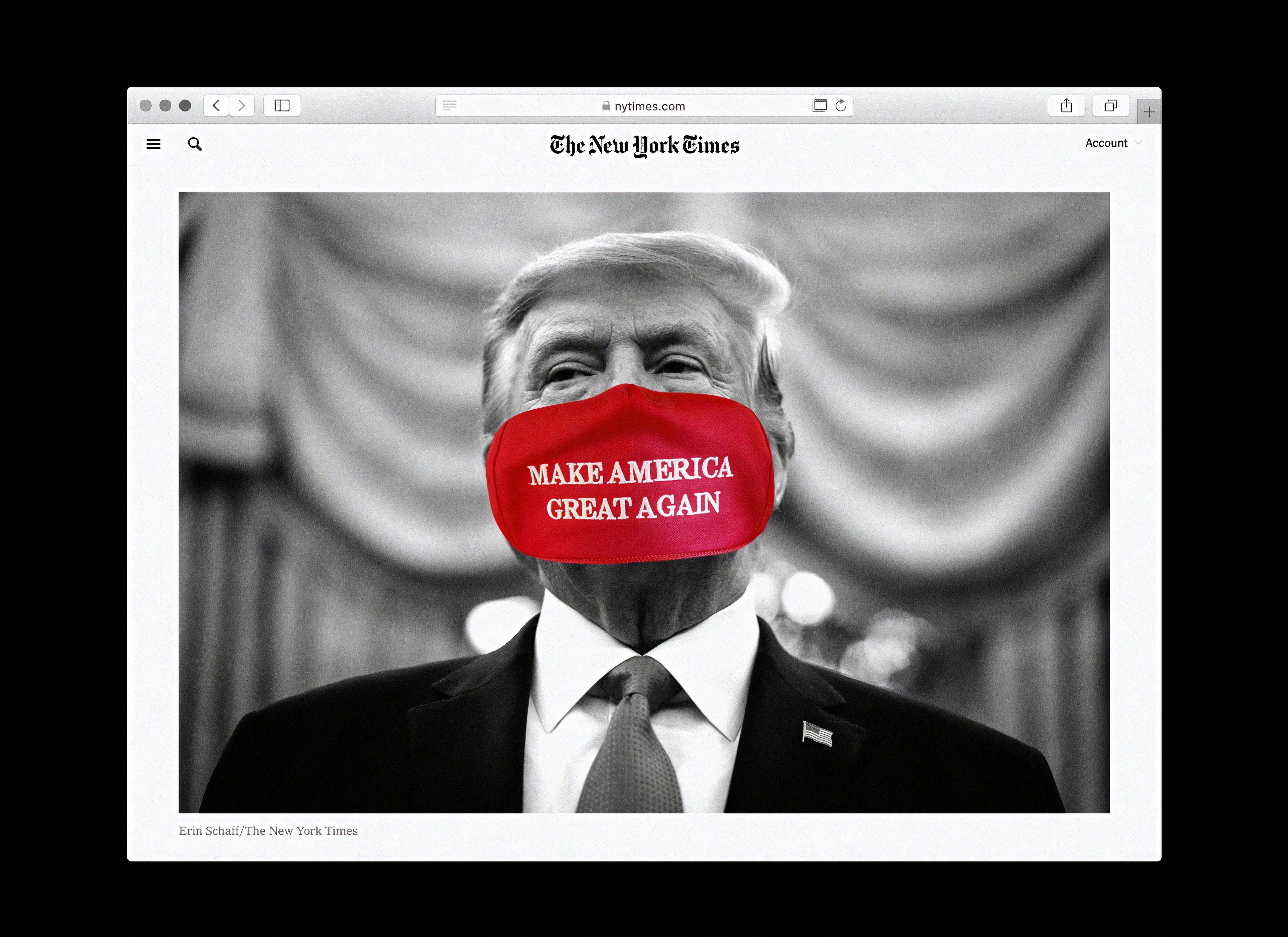

Kako su dezinformacije eksplodirale prvo tijekom pandemije covida-19, a potom i uslijed uzdrmane geopolitičke situacije obilježene brojnim novim sukobima diljema svijeta, korisnici društvenih mreža okrenuli su se AI chatbotovima za provjeru činjenica – samo da bi naišli na još više neistina, što naglašava njihovu nepouzdanost kao alata za provjeru informacija.

S obzirom na to da tehnološke platforme smanjuju broj ljudskih provjeravatelja činjenica, korisnici sve češće traže pouzdane informacije putem chatbotova koji koriste umjetnu inteligenciju – uključujući xAI-jev Grok, OpenAI-jev ChatGPT i Googleov Gemini.

„Hej @Grok, je li ovo istina?“ postalo je uobičajeno pitanje na platformi X Elona Muska, gdje je AI asistent ugrađen, odražavajući sve veću potrebu korisnika za trenutnim razotkrivanjem dezinformacija.

No, odgovori su često i sami puni netočnosti.

This photo comes from 2023: https://t.co/5HwWGBS8V8

— Dawid (@dawid123d) June 3, 2025

There is no ongoing protest on the border, it's fake news.

Groku nije za vjerovati

Grok – koji je pod povećalom jer je u nasumične upite umetao teoriju zavjere krajnje desnice o „bijelom genocidu“ – pogrešno je identificirao staru snimku zračne luke u sudanskom glavnom gradu Kartumu kao raketni napad na pakistansku zračnu bazu Nur Khan tijekom nedavnog sukoba s Indijom.

„Rastuće oslanjanje na Grok kao provjeravatelja činjenica dolazi u trenutku kada su X i druge velike tehnološke tvrtke smanjile ulaganja u ljudske provjeravatelje činjenica“, izjavila je McKenzie Sadeghi, istraživačica organizacije za nadzor dezinformacija NewsGuard, za AFP, a prenosi Japan Today.

„Naše istraživanje je opetovano pokazalo da AI chatbotovi nisu pouzdani izvori vijesti i informacija, osobito kada se radi o aktualnim događajima“, upozorila je.

10 vodećih chatbotova ponavlja netočnosti i propagandu

NewsGuardovo istraživanje pokazalo je da je 10 vodećih chatbotova sklono ponavljanju netočnosti, uključujući ruske propagandne narative te lažne ili zavaravajuće tvrdnje povezane s nedavnim australskim izborima.

U nedavnoj studiji osam AI pretraživačkih alata, Tow Centar za digitalno novinarstvo pri Sveučilištu Columbia otkrio je da su chatbotovi „općenito loši u odbijanju odgovora na pitanja na koja ne znaju točno odgovoriti, nudeći umjesto toga pogrešne ili spekulativne odgovore“.

Ne samo da potvrđuje lažne informacije, nego stvara narative

Kada su AFP-ovi provjeravatelji činjenica u Urugvaju pitali Gemini o AI-generiranoj slici žene, chatbot ne samo da je potvrdio njezinu autentičnost, već je i izmislio detalje o njezinu identitetu i lokaciji gdje je navodno snimljena.

Grok je nedavno proglasio navodni video džinovske anakonde koja pliva Amazonom „autentičnim“, čak navodeći znanstvene ekspedicije koje su navodno potvrdile tu neistinu.

AI chatbotovi sve češći odabir

U stvarnosti, video je generiran pomoću umjetne inteligencije, izvijestili su AFP-ovi provjeravatelji iz Latinske Amerike, navodeći da su se mnogi korisnici pozivali na Grokovu procjenu kao dokaz da je snimka stvarna.

Ovakvi nalazi izazivaju zabrinutost jer ankete pokazuju da se korisnici sve više odmiču od tradicionalnih tražilica i okreću AI chatbotovima za prikupljanje i provjeru informacija.

Meta obustavila provjeru činjenica

Taj se zaokret događa i u trenutku kada je Meta ranije ove godine objavila da obustavlja svoj program vanjske provjere činjenica u SAD-u, prepuštajući razotkrivanje neistina običnim korisnicima kroz model „Community Notes“, koji je popularizirala platforma X.

Istraživači su više puta dovodili u pitanje učinkovitost tog modela u borbi protiv dezinformacija.

Ljudska provjera činjenica već dugo izaziva prijepore u izrazito polariziranom političkom okruženju, posebno u Sjedinjenim Državama, gdje konzervativni krugovi tvrde da se njome guši sloboda govora i cenzurira desni sadržaj – što profesionalni provjeravatelji odlučno odbacuju.

AFP trenutačno surađuje s Facebookovim programom provjere činjenica na 26 jezika, uključujući Aziju, Latinsku Ameriku i Europsku uniju.

Kvaliteta i točnost AI chatbotova može varirati, ovisno o tome kako su trenirani i programirani, što izaziva zabrinutost da bi njihov sadržaj mogao biti podložan političkom utjecaju ili kontroli.

O kakvom bijelom genocidu priča Grok?

Muskova tvrtka xAI nedavno je za umetanje izraza „bijeli genocid“ u Grokove odgovore okrivila „neovlaštenu izmjenu“.

Kada je AI stručnjak David Caswell pitao Grok tko je mogao promijeniti njegove sustavne upute, chatbot je naveo Muska kao „najvjerojatnijeg“ krivca.

Musk, južnoafrički milijarder i pristaša Donalda Trumpa, ranije je promovirao neutemeljenu tvrdnju da južnoafričke vlasti „otvoreno pozivaju na genocid nad bijelcima“.

„Vidjeli smo kako AI asistenti mogu izmišljati rezultate ili davati pristrane odgovore nakon što ljudi promijene njihove upute“, rekla je Angie Holan, direktorica Međunarodne mreže za provjeru činjenica, za AFP.

„Posebno me zabrinjava način na koji je Grok postupao s vrlo osjetljivim pitanjima nakon što su mu dane unaprijed odobrene upute.“

Kakvo je tvoje mišljenje o ovome?

Pridruži se raspravi ili pročitaj komentare

Srbija

Srbija

Bosna i Hercegovina

Bosna i Hercegovina

Slovenija

Slovenija